第一節 - 訊號取樣與離散時域

要讓電腦處理訊號,必須預先讓訊號變成數字,也就是讓訊號經過「取樣」與「量化」兩個步驟。取樣把時間變成離散,量化把振幅變成離散 [1]。不過因為量化只會造成頻譜量值有極細微的誤差,整體而言不會造成太大的影響,並不在我們關心的範圍之內,本節只會討論「取樣」這個動作,它對頻譜會造成什麼樣的變化。

取樣 (sampling),顧名思義,就是從一段連續訊號之中每隔固定時間 擷取出訊號的值,形成新的離散訊號,實作上會倚賴「類比數位轉換器 (analog-to-digital converter,簡稱 ADC) [2][3]」內部的電路元件運作。

在本章以及往後的章節,我們一律稱 為取樣間隔,其倒數為取樣頻率。其他教材有時稱 為取樣週期,但是筆者認為「週期」一詞會與波的週期混淆,所以本書不使用它。

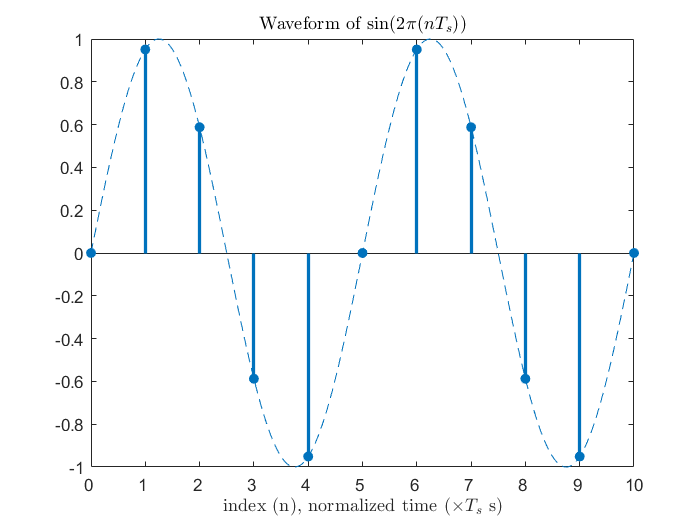

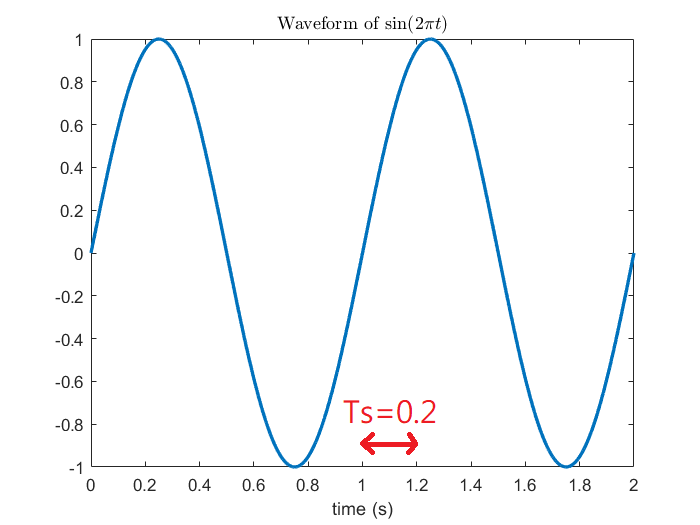

連續時域 (取樣前) | 離散時域 (取樣後) |

上圖是取樣前後的對照,取樣前的訊號我們稱之屬於連續時域,取樣後的訊號屬於離散時域,離散時域上的時間點又稱為取樣點。因為第二章介紹的是適用於「連續時間」的傅立葉級數與轉換 (CTFS 和 CTFT),那套理論很顯然地沒辦法應用到離散時域上,因此本章目的便在於從第二章的理論開始一樣用邏輯推演出適合離散時間的版本。

Last updated